Der Nutzer findet sich also in einem digitalen, dreidimensionalen Raum wieder. Um die virtuelle Welt ganzheitlich erfahren zu können, spielen Interaktionsmöglichkeiten eine bedeutende Rolle. Sie bewirken eine Verschmelzung zwischen dem Nutzer und seiner Umgebung und überwinden die Barrieren, die gewohnte digitale Medien zwangsläufig mit sich bringen. Es entsteht eine intensivere Erfahrung, die so nur in der virtuellen Realität möglich ist. Die Schnittstelle zwischen Nutzer und Medium bildet eine handelsübliche VR-Brille. In diesem Fall handelt es sich um die HTC VIVE.

Gesucht wird ein Interaktionskonzept, das den Nutzer in die virtuelle Welt integriert, ohne ihn dabei von den grundlegenden Geschehnissen abzulenken. Hierbei spielt die User Experience (kurz UX) eine tragende Rolle. Sie beschriebt die Erfahrung eines Nutzers mit einem Produkt oder einem Service und wird durch sogenannte User Tests erprobt. In unserem Fall wurde schnell klar, dass virtuelle Realitäten und VR-Brillen noch sehr neue Technologien sind. Die wenigsten Nutzer haben bereits Vorkenntnisse oder sind sogar erfahren im Umgang mit diesem Medium. Sogar die Studenten am Campus, die regelmäßiger in Kontakt mit virtuellen Anwendungen kommen, zeigten sich schnell verloren oder überfordert.

Die Interaktionsmöglichkeiten einer digitalen, virtuellen Welt scheinen vergleichsweise grenzenlos. Für eine gute User Experience jedoch gilt es den Nutzer nicht unnötig zu belasten und sich lediglich auf die zentralen Aspekte der Szene zu beschränken. Schließlich soll das Orchester so natürlich und einfach wie möglich erlebbar sein. Zu viele verschiedene Interaktionsmöglichkeiten würden diese Erfahrung negativ beeinträchtigen. Es stellt sich also die Frage, welche Interaktionsmöglichkeiten von fundamentaler Bedeutung für eine umfangreiche Erfahrung sind und welche man zur leichteren Verständlichkeit weglässt.

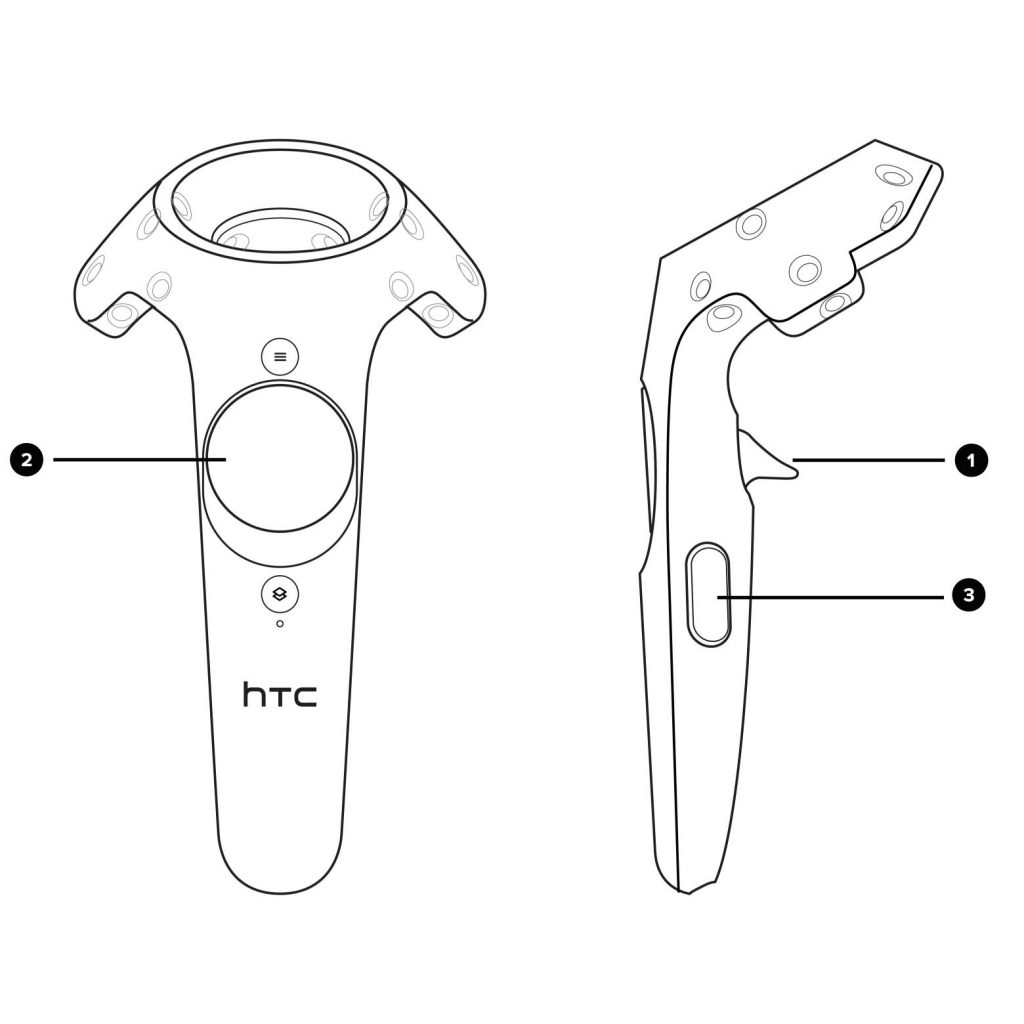

Auch die Hardware, also der Controller der HTC VIVE, limitiert die Anzahl der geeigneten Anwendungen. Er bietet einen sogenannten „Trigger“ (1) für den Zeigefinger und ein Touchpad (2) für den Daumen, dass ebenfalls als Knopf funktioniert. Darüber hinaus gibt es noch den „Grip Button“ (3), der durch ein Zusammenpressen der Hand aktiviert wird. Letzterer erwies sich bereits in der Vergangenheit als unintuitiv und unzuverlässig. Nutzer können die meisten Funktionen von der Computermaus übertragen, ein Zugreifen erscheint allerdings noch zu abstrakt. Es besteht die Option einen zweiten Controller oder sogar die Position des Headsets zu verwenden, um weitere Interaktionsmöglichkeiten zu schaffen. Der Schlüssel jedoch liegt in einer leichten Verständlichkeit der Anwendung und folglich nicht in der größtmöglichen Anzahl an verschiedenen Interaktionen.

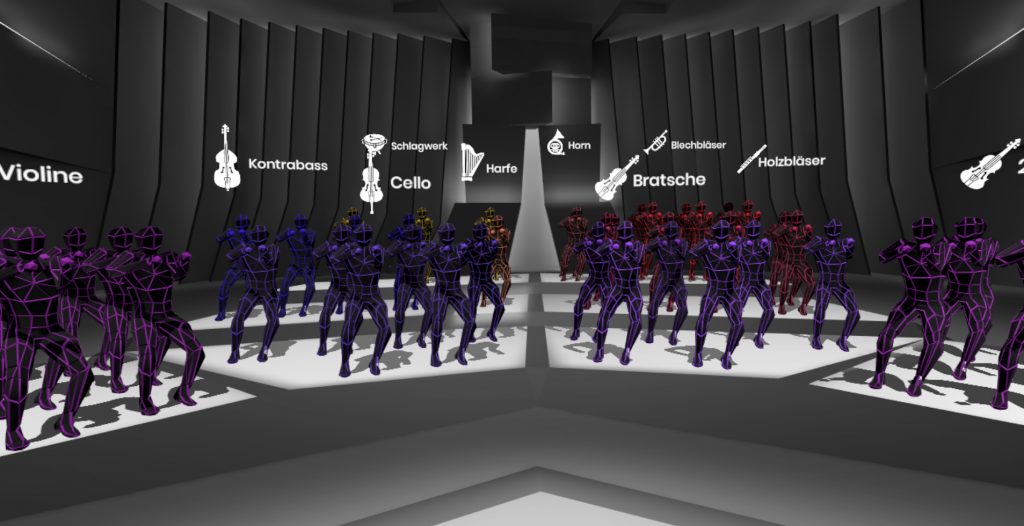

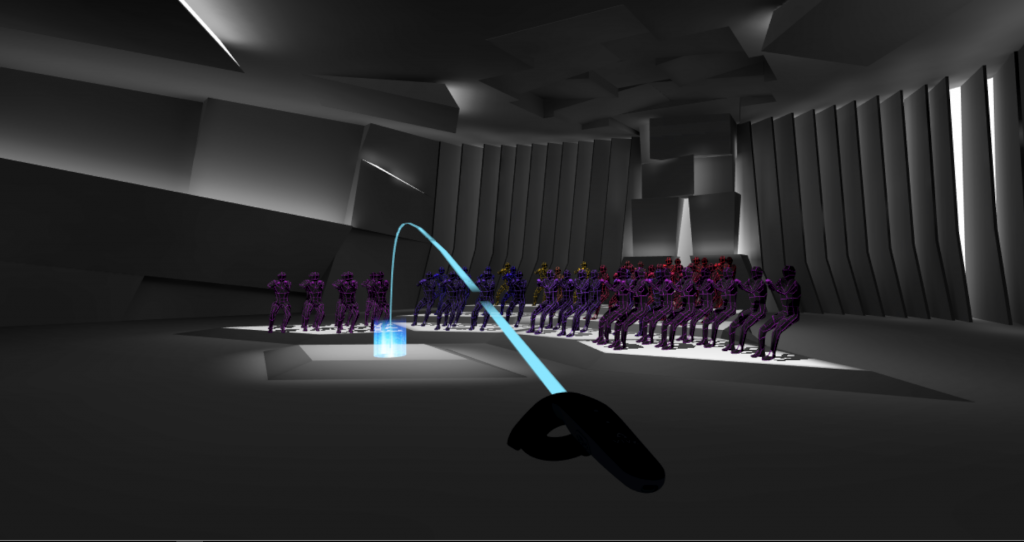

Reduziert man die geplante Szene auf das Wesentliche, so handelt es sich um einen Konzertraum mit einem spielenden Orchester. Das Hauptaugenmerk liegt hier auf den Bewegungsdaten der Musiker und den Soundspuren der jeweiligen Instrumentengruppen. Sowohl die Bewegungen als auch der Klang finden im dreidimensionalen Raum statt. Die Geräuschkulisse verändert sich abhängig von der Position des Nutzers und die Bewegungen der Figuren lassen sich aus unterschiedlichen Perspektiven analysieren. Es muss dem Nutzer also möglich sein sich im Raum zu bewegen. Hier liegt schließlich auch der größte Vorteil der virtuellen Realität. Letztendlich fiel die Entscheidung auf eine Teleportfunktion. Diese wird regelmäßig von verschiedenen Anwendungen genutzt und ist somit zumindest einigen Nutzern bereits bekannt. Nicht grundlos konnte sich der Teleport bisher behaupten: ein gradliniges Laufen wie es beispielsweise in Computerspielen angewendet wird, führt in den aktuellen Brillen noch schnell zu Übelkeit und einem unangenehmen Flimmereffekt. Der Teleport umgeht dieses Problem, da die Position schlagartig gewechselt wird. Außerdem ermöglicht sich so ein besserer Vergleich der Audiospuren. Der Nutzer kann sich von der linken auf die rechte Seite der Bühne teleportierten und so den unterschiedlichen Klang nachvollziehen. Die Umsetzung unserer Teleportation hält sich dabei an den bisherigen Standard und wird mit dem Touchpad aktiviert. Legt der Nutzer seinen Daumen auf das Bedienfeld, erscheint eine Kurve, die zu einem Punkt auf dem Boden führt. Durch ein Klicken und Loslassen des Touchpads teleportiert man sich zu dem markierten Punkt. Der Nutzer kann sich nun im Raum bewegen und die Szene audiovisuell erkunden.

Jedoch ist er bisher lediglich ein Beobachter. Es fehlt noch die Interaktion mit seiner Umgebung.

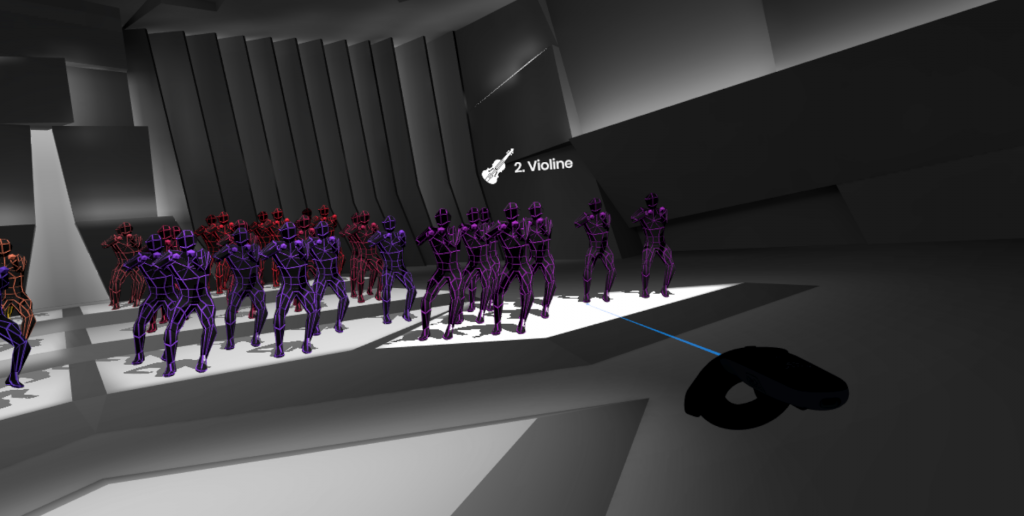

Zunächst bedarf es einer weiteren Interaktionsmöglichkeit. Nachdem das Touchpad für die Teleportation genutzt wird bleibt der „Trigger“ für die Interaktion mit den Musikern. Dieser bietet ebenfalls zwei Interaktionsstufen: Zuerst lässt er sich anziehen und in dieser Position halten. Durch ein stärkeres Ziehen wird dann ein Klick ausgelöst. Die erste Stufe aktiviert das sogenannte Zeigewerkzeug, also einen laserartigen Strahl der gradlinig aus dem Controller austritt. Mit ihm kann der Nutzer auf Objekte zeigen. Handelt es sich um ein aktives, auswählbares Ziel, wird dieses heller, wenn der Strahl es trifft. Hier sind es die Plattformen der jeweiligen Musiker die reagieren. Trifft der Laser auf eine Schaltfläche, so erscheint ein Icon und die jeweilige Instrumentengruppe über den Köpfen der Musiker. Als Auswahl werden die Plattformen genutzt, weil diese statisch sind und in Kombination mit der Bühnenstruktur eine Orientierung im Raum ermöglichen, während sich die einzelnen Figuren bewegen und gegenseitig verdecken.

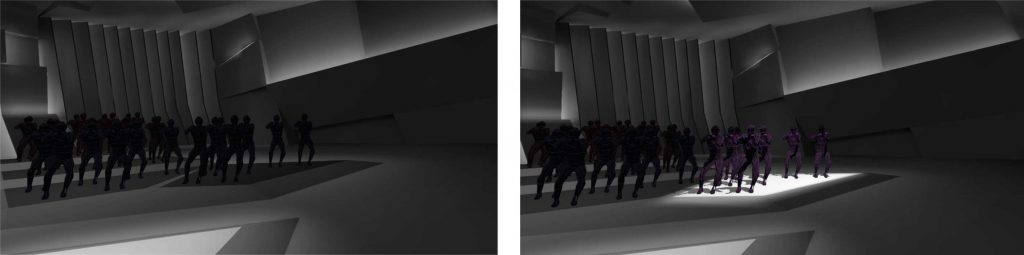

Nun kann sich der Nutzer im Raum bewegen und auf eine Informationsstruktur zugreifen, die ihm die Besetzung des Orchesters erklärt. Zuletzt soll er in der Lage sein, aktiv in das Geschehen einzugreifen, indem er einzelne Instrumentengruppen nach Belieben ein- oder ausschaltet. Er kann also das Klangbild aktiv manipulieren und ein besseres Verständnis für das Orchester und seine einzelnen Klanggruppen entwickeln. Um diese Interaktion durchzuführen, muss der Nutzer den „Trigger“ bis zum Klick durchdrücken. Eine so deaktivierte Plattform wird dunkel und die Audioquelle stumm geschaltet, bis sie wieder auf dem gleichen Weg aktiviert wird. Der Nutzer kann also theoretisch das ganze Orchester verstummen lassen, indem er alle Plattformen deaktiviert oder sich auf diesem Weg einzelne Instrumentengruppen gesondert anhören. Er ist nun mit wenigen Interaktionsmöglichkeiten in der Lage sich schnell in die Szene einzugewöhnen und trotzdem umfangreiche Auswirkungen auf das Geschehen zu haben.

Zuletzt spielt die Dirigentenplattform erneut eine gesonderte Rolle: Befindet sich der Nutzer auf der Plattform, werden allen Informationen gleichzeitig eingeblendet. Es entsteht ein Überblick über das gesamte Orchester. Deaktiviert man jedoch die Plattform des Dirigenten, pausiert das gesamte Orchester und alle Musiker verharren in ihrer Bewegung. So lassen sich von der Übersichtsposition verschiedene Einstellungen im direkten Vergleich erproben.